HISTORIA DEL PROCESAMIENTO DE DATOS

Los primeros elementos empleados para contabilizar animales y/o personas fueron pequeñas piedras o semillas, por falta de un sistema de escritura .

3000 - 3500 AC

Por los Babilonios fue descubierto el Ábaco, constituyó el primer dispositivo manual de cálculo. Servía para representar números en el sistema decimal y contar, permitiendo realizar operaciones aritméticas sencillas. Consta de un marco de madera dividido en dos partes, contiene una serie de varillas verticales que corresponden cada una a un dígito o cifra. En la parte inferior de cada varilla hay cinco discos denominados cuentas, en la superior 2 discos denominados quintas.

2600

AC apareció el ábaco chino, denominado Suan–Pan. Y en forma similar nació en Japón otro modelo de ábaco que se denominó Soroban.

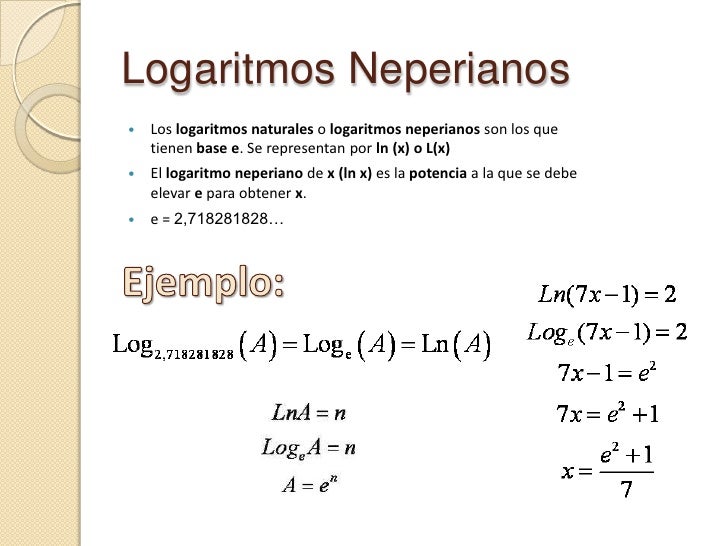

1614

El escocés John Napier desarrolló los logaritmos (neperianos o naturales) que permitieron reducir complejas multiplicaciones y divisiones en sumas y restas.

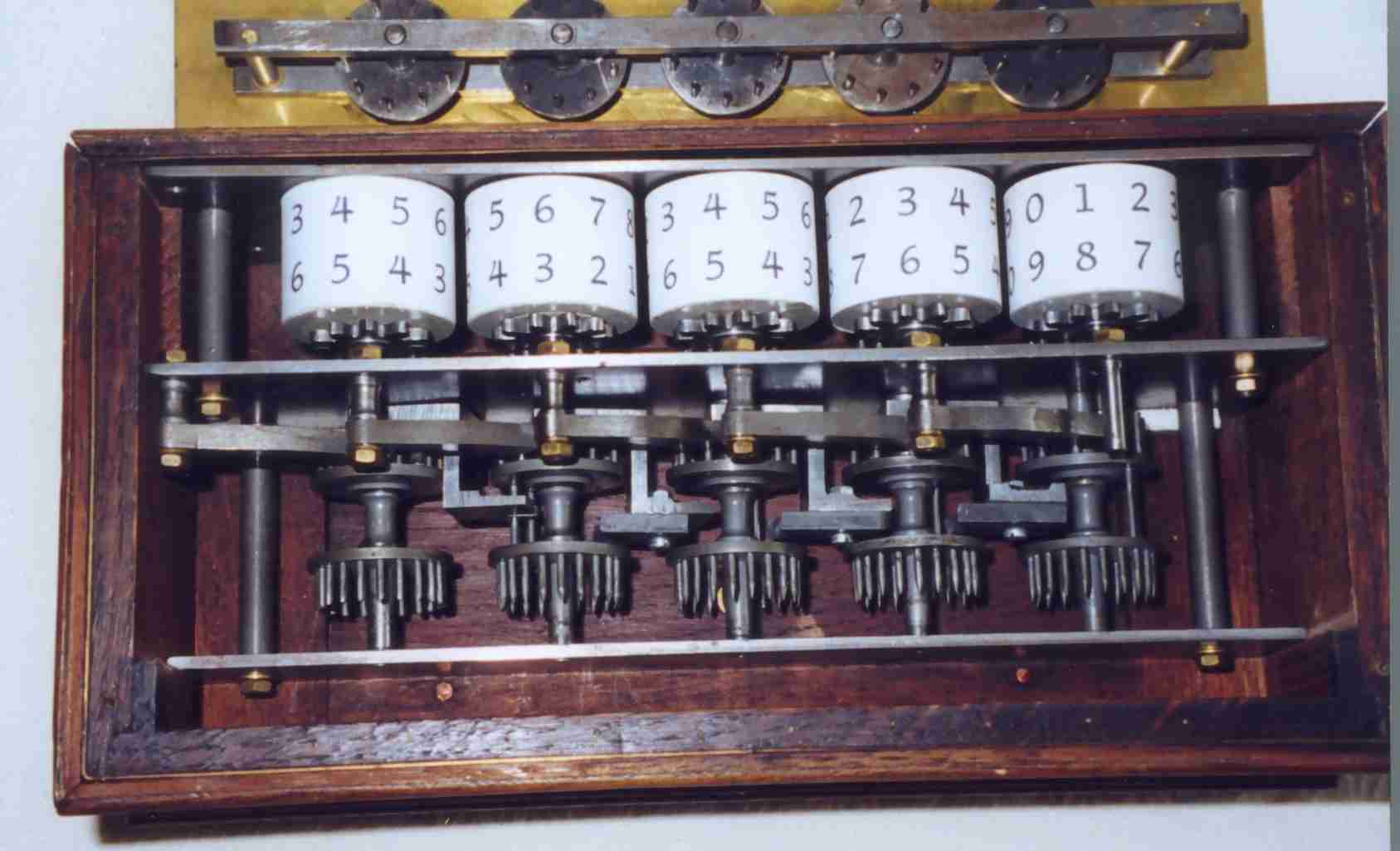

1642

El matemático, filósofo y físico francés Blas Pascal desarrolla la primera máquina de sumar denominada “La Pascalina” o Máquina aritmética de Pascal que realizaba cálculos de 8

dígitos. A base de ruedas dentadas que simulaba el funcionamiento del ábaco. Realizaba operaciones de sumas y restas mostrando el resultado por una serie de ventanilla.

1650

Patridge, basándose en los descubrimientos de Napier, inventó la Regla de Cálculo, pequeña regla deslizante sobre una base fija en la que figuraban diversas escalas para la realización de determinadas operaciones. Este dispositivo de cálculo ha sido muy utilizado hasta los años ´60 cuando las calculadoras electrónicas constituyeron su mejor sustituto.

1671

Leibniz, perfecciona la Pascalina, agregándole capacidad de multiplicación, división y raíces cúbicas y en 1679 crea y presenta el modo aritmético binario basado en ceros y unos, el cual se emplearía siglos más tarde para estandarizar la simbología utilizada para procesar la información en las computadoras.

1805

El francés Joseph Jacquard construyó un telar automático que realizaba un control sobre las agujas tejedoras, utilizando tarjetas perforadas que contenían los datos para el control de las figuras y dibujos a tejer. El telar de Jacquard se considera como la primera máquina mecánica programada.

1822

Charles Babbage, el matemático inglés y profesor de la Universidad de Cambridge diseño la máquina de diferencias o Diferencial, basada en fundamentos mecánicos con ruedas dentadas, su aplicación más importante fueron la resolución de funciones y la obtención de tablas de dichas funciones (ej. x2) Fue la primera máquina de uso específico.

1833

El mismo Charles Babbage diseño su segunda máquina, denominada Máquina Analítica, capaz de realizar todas las operaciones matemáticas y con posibilidades de ser programable por medio de tarjetas de cartón perforado. Con esta máquina Babbage consiguió definir los fundamentos teóricos de las computadoras actuales. Por esta máquina y su estructura, Babbage es considerado actualmente como el padre de la Informática. Ada Byron (condesa, hija del famoso poeta Lord Byron) fue la primera persona que realizó programas para la máquina analítica de Babbage, de tal forma ha sido considerada como la primera programadora de la historia.

1854

El matemático inglés George Boole desarrolló la teoría de álgebra de Boole, que permitió a sus sucesores el desarrollo matemático del álgebra binaria y con ella la representación de circuitos lógicos, llamada “Teoría de los circuitos lógicos”.

1885

El norteamericano y funcionario de la oficina del censo de EE UU Herman Hollerith vio como se tardaban 10 años en realizar el censo anual de su país y observó que la mayoría de las preguntas tenían como respuesta un sí o un no, lo que hizo idear una tarjeta perforada para contener la información. Construyó su Máquina Censadora o Tabuladora que fue capaz de reducir el trabajo manual a la tercera parte, el censo de 1890 tardó sólo 3 años.

1895

Hollerith incluyó en su máquina tabuladora la operación de sumar con el fin de utilizarla para la contabilidad de los Ferrocarriles Centrales de Nueva York. Fue la primera aplicación comercial y lo introdujo en el mundo de los negocios . * 1896 se funda la empresa Tabulating Machines Company, la cual se fusionó con otras empresas en el año 1924.

1924

se crea IBM International Business Machines.

1937

Howard Aiken, de la Universidad de Harvard, desarrolla la idea de Babbage junto con un equipo de científicos de su departamento e ingenieros de IBM, dando como resultado la construcción de una calculadora numérica basada en el uso de relés electromagnéticos, ruedas dentadas y embragues electromecánicos, configurando la primera computadora electromecánica. Más conocida como Mark-I.

1938

Atanasoff (profesor de la Universidad de Iowa) y Berry construyeron una máquina electrónica que operaba en binario, fue la primera máquina de calcular digital.

1940 y 1945

Eckert y Mauchly construyeron a petición del Ministerio de Defensa de los EE UU., la primera computadora electrónica ENIAC (Electronic Numerical Integrator and Calculator)

1944

Neumann desarrolló la idea de una computadora donde los programas se podían modificar.

1951

Se construyó UNIVAC – I (por los creadores de la ENIAC) la primera computadora creada en serie. Y luego MANIAC I, MANIAC II y la UNIVAV II.

1952

Neumann construyó una máquina llamada EDVAC (Electronic Discrete Variable Automatic Computer).

Los CCTV se personalizan para adaptarse a la naturaleza y las necesidades de seguridad de cada cliente. El sistema CCTV ideal debería proporcionar imágenes de buena calidad de día y también de noche, además debería ser fácil de usar y ser flexible, para grabar las imágenes que sirvan como pruebas de forma útil y ayudar a analizar los incidentes. Si las imágenes no tienen calidad, entonces de poco servirá.

Los CCTV se personalizan para adaptarse a la naturaleza y las necesidades de seguridad de cada cliente. El sistema CCTV ideal debería proporcionar imágenes de buena calidad de día y también de noche, además debería ser fácil de usar y ser flexible, para grabar las imágenes que sirvan como pruebas de forma útil y ayudar a analizar los incidentes. Si las imágenes no tienen calidad, entonces de poco servirá.